2016年,就在约书亚·布朗(Joshua Brown)被他的特斯拉Autopilot推向死亡的几周前,我请求美国参议院商业、科学和交通委员会监管人工智能在汽车中的使用。然而,我的请求和布朗的死亡都未能促使政府采取行动。自此之后,在美国,汽车人工智能至少与25起确认导致死亡的事故和数百起受伤和财产损失事件有关。

业界和政府对技术理解的缺乏是令人震惊的。人们不知道,人工智能驾驶车辆所包括的实际自动驾驶模式和多数汽车带有的高级驾驶辅助系统ADAS,与ChatGPT和其他大语言模型(LLM)均基于相同的原理。这些系统控制汽车的横向和纵向位置、变换车道、刹车和加速,不用等待坐在方向盘后面的人发出命令。

这两种人工智能均使用统计推理来猜测下一个单词或短语,或转向输入应该是什么,采用最近使用的词汇或动作来计算权重。如果你在谷歌搜索窗口输入“now is the time”(现在是时候了),你会得到结果“now is the time for all good men”(现在是属于所有好人的时刻)。而当你的汽车检测到前方道路上有物体时,哪怕只是一个影子,也要当心汽车的自动驾驶模块会突然刹车。

无论是大语言模型中的人工智能还是自动驾驶汽车中的人工智能,都无法“理解”情形、背景或未观察到的因素,而人在类似情形下是会考虑到的。不同的是,语言模型可能会对你胡说八道,而自动驾驶汽车可能会致你于死地。

2021年末,尽管因为我敢于说出汽车人工智能的危险,我的人身安全受到威胁,但我同意与美国国家公路交通安全管理局合作,担任高级安全顾问。我之所以能胜任这份工作,是因为我拥有人机联合系统设计方面的博士学位,以及20年的无人系统设计和测试经验,其中包括一些现在用于军事、采矿和医学的无人系统。

在美国国家公路交通安全管理局的工作让我近距离观察了交通系统人工智能的现实应用,也了解了监管系统的内在问题,尤其是在当前趋于的环境下。我根据深入的了解,形成了5条实用见解。我相信它们可以为行业和监管机构提供一定的指导。

自动驾驶汽车的支持者经常声称,我们越早摆脱人类驾驶员,我们在道路上就越安全。他们引用了美国国家公路交通安全管理局的统计数据,即94%的事故是由人类驾驶员造成的。但这个统计被断章取义,是不准确的。正如美国国家公路交通安全管理局自己在报告中指出的那样,驾驶员的错误是“事故因果链中的最后一环……不要将它解读为撞车事故的原因”。换句话说,还有许多其他可能的原因,比如照明不足和糟糕的道路设计。

此外,自动驾驶汽车将比人类驾驶汽车更安全的说法忽略了从事过软件开发的人都非常清楚的一点:软件代码非常容易出错,而且系统越复杂,这个问题越严重。

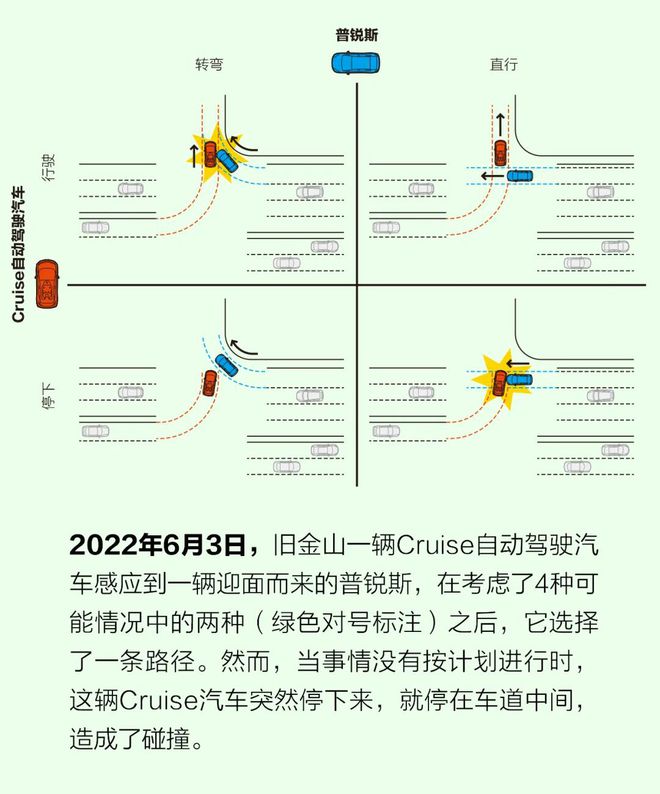

想想最近那些因软件缺陷导致的事故吧。2021年10月,一辆Pony.ai无人驾驶汽车撞上了指示牌;2022年4月,一辆TuSimple牵引拖车撞上了混凝土护栏;2022年6月,一辆Cruise自动驾驶出租车在左转时突然停下;2023年3月,另一辆Cruise汽车追尾了一辆公交车。

这些和许多其他事件清楚地表明,人工智能并没有终结人为错误在道路事故中的角色,而是仅仅是将这个角色从事件链的末端转移到了起点——人工智能本身的编码。因为这些错误是隐藏的,所以很难减少。无论是模拟还是在真实世界中的测试(这一点无疑更重要)都是减少此类错误的关键,尤其是在安全关键系统中。然而,如果没有足够的政府监管和明确的行业标准,为了快速将产品推向市场,自动驾驶汽车企业很可能会偷工减料。

大语言模型猜测接下来会出现哪些单词和短语,是通过查阅在先存数据训练期间形成的档案实现的。自动驾驶模块做出类似的猜测,决定如何绕过障碍物,是根据训练期间提供的标记图像数据库实现的,比如这是一辆汽车,这是一个行人,这是一棵树,等等。但不是每种可能性都可以建模,因此大量故障模式很难预测。在所有条件相同的情况下,在同一段道路上,在一天的不同时间内,自动驾驶汽车的行为可能会有很大不同,这可能是由于太阳角度不同导致的。任何尝试过大语言模型的人都知道,只要改变提示词的顺序,立即会看到系统给出不同的回复。

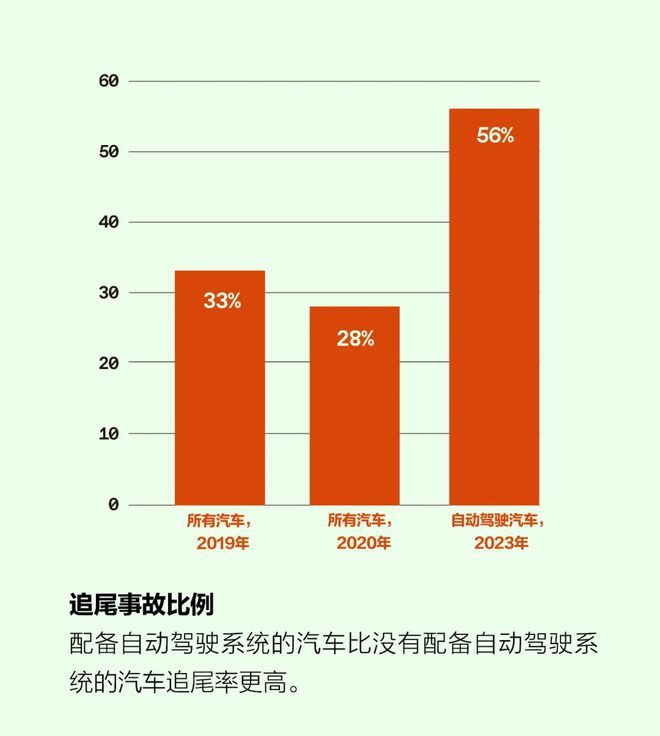

幻影制动是一种以前没有预料到的故障模式。自动驾驶汽车无缘无故突然紧急刹车,这可能会导致紧随其后的车辆和更后面的其他车辆发生追尾。幻影制动已经发生在许多不同制造商制造的自动驾驶汽车上,也发生在配备ADAS的汽车上。

这些事故的原因仍然是个谜。最初,专家将原因归于人类驾驶员在自动驾驶汽车后面跟得太近(他们的评估经常会引用“94%的事件都是因为驾驶员错误”这个具有误导性的统计数据)。然而,美国国家公路交通安全管理局收到了越来越多这类事故的报告。例如,2022年5月,美国国家公路交通安全管理局致函特斯拉,指出该机构收到了758起关于Model 3和Model Y汽车发生幻影制动的投诉。2023年5月,德国《商报》报道了1500起关于特斯拉汽车制动问题的投诉,以及2400起关于突然加速的投诉。杏彩体育官网现在看来,自动驾驶汽车遭遇追尾事故的概率大约是人类驾驶汽车的两倍。

显然,人工智能没有发挥出应有的作用。此外,这不仅仅是一家企业的问题,所有利用计算机视觉和人工智能的汽车企业都可能存在这个问题。

随着其他类型的人工智能开始渗透到社会,标准机构和监管机构必须明白,人工智能的故障模式不会遵循可预测的路径。他们还应该警惕汽车企业倾向于为糟糕的技术行为开脱,反而指责是人在滥用或误用人工智能。

10年前,IBM基于人工智能的超级电脑“沃森”的崛起引起巨大恐慌,它就是今天大语言模型的前身。人们担心人工智能很快会导致大量失业,尤其是在医疗领域。与此同时,一些人工智能专家表示,我们应该停止培训放射科医生。

这些担心没有成为现实。虽然沃森可能擅长猜测,但它没有真正的知识,特别是无法在不确定的情况下作出判断,以及根据不完善的信息决定行动。今天的大语言模型也没有什么不同:底层模型根本无法处理信息的缺乏,也没有能力权衡它们的估计在这种情形下是否足够好。

这些问题在自动驾驶领域很常见。2022年6月,Cruise 自动驾驶出租车发生事故时,该车决定在两辆车之间猛然左转。正如汽车安全专家迈克尔·伍恩(Michael Woon)在一份事故报告中详细描述的那样,这辆车正确地选择了一条可行的路径,但在转弯途中,它猛踩刹车,停在了十字路口中间。它也许猜想右边车道上一辆迎面而来的汽车要转弯,但按照那辆汽车的行驶速度,这个转弯在物理上是不可能的。这种不确定性让这辆Cruise感到困惑,它作出了最糟糕的决定。迎面而来的普锐斯并没有转弯,而是猛地撞上了这辆Cruise,导致两辆车内的乘客受伤。

Cruise汽车与紧急救援人员(紧急救援人员默认在重大不确定区域操作)的互动也存在许多问题,包括Cruise汽车穿越消防和救援现场,以及驶过落在地上的电线。在一次事故中,员不得不敲碎Cruise汽车的窗户,将它从现场挪走。Cruise在自动驾驶出租车业务上的主要竞争对手Waymo也经历了类似的问题。

这些事件表明,即便神经网络可以对大量图像进行分类,并提出一系列常见设置下有效的操作,但当世界与它们的训练数据不匹配时,它们甚至难以执行基本操作。大语言模型和其他形式的生成式人工智能也是如此。面对不确定性时,这些系统缺乏判断力,这是真正知识的关键前提。

因为只有经过大量相关数据的训练,神经网络情况才能有效,所以数据的质量至关重要。但是这种训练不是一劳永逸的:模型经过训练后再被送去实践,也不能永远表现良好。在驾驶这类动态环境中,模型必须不断更新,反映新型汽车、自行车和小型摩托车、建筑区域、交通模式等。

在2023年3月的事故中,一辆Cruise汽车撞上了一辆铰接公交车的后部,专家们感到非常惊讶,因为许多人认为对于一个配备激光雷达、雷达和计算机视觉的系统来说,这种事故几乎不可能发生。Cruise将事故归咎于一个有缺陷的模型,该模型根据正常公交车的尺寸猜测这辆公交车后部的位置;此外,该模型还拒绝了所检测到的该公交车的正确激光雷达数据。

这个事例突出表明保持人工智能模型现时性的重要性。“模型漂移”是人工智能的一个已知问题,当输入和输出数据之间的关系随时间变化时,就会发生这种问题。例如,如果一个自动驾驶车队在一个城市遇到一种类型公交车,然后车队移动到另一个城市遇到不同类型的公交车,那么检测公交车的基础模型就可能发生漂移,这会导致严重的后果。

这种漂移不仅影响人工智能在交通领域的工作,也影响新成果不断改变我们对世界的认知的其他领域。这意味着大语言模型无法学习新的现象,直到它失去了新颖的先进性,并且频繁出现到足以被纳入数据集。维护模型的现时性只是人工智能需要定期维护的许多方式之一,未来任何关于人工智能监管的讨论都要必须解决这一关键问题。

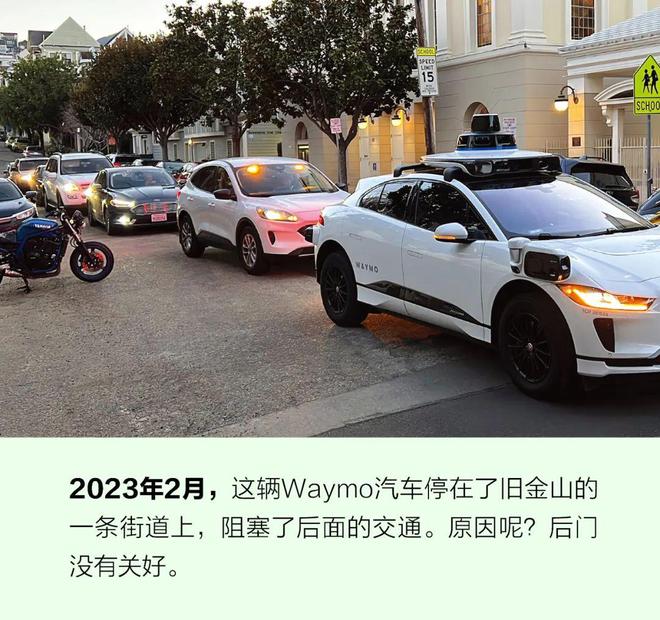

在遇到不能推理和不能解决不确定性的时刻,自动驾驶汽车的设计是立即停下来。这是一个重要的安全特性。但正如Cruise、特斯拉和Waymo所表现的那样,如何处置这种突然停车会造成意想不到的挑战。

一辆突然停下来的汽车可能会堵塞道路和交叉路口,有时长达几个小时,阻碍交通,阻止紧急救援车辆进入。各家企业已经建立了远程监控中心和快速行动小组来缓解这种拥堵和混乱,但至少在旧金山,有数百辆自动驾驶汽车行驶在路上,城市官员质疑它们的响应质量。

自动驾驶汽车依靠无线连接来保持道路感知,但若失去连接会发生什么呢?一名驾驶员体会到了这种行路艰难,他的车曾被困在20辆与远程操作中心失去联系的Cruise汽车队伍中,动弹不得,导致了大规模的交通堵塞。

当然,任何新技术都可能遇到成长的烦恼,但如果这些烦恼变得很严重,它们将削弱公众的信任和支持。在科技友好的旧金山,人们曾对自动驾驶汽车持乐观态度,但由于这座城市正在经历大量的问题,现在这种态度已经转向负面。如果一辆自动驾驶汽车突然停下来,造成一个人无法及时到达医院而死亡杏彩体育官方,这种情绪最终可能会导致公众拒绝这项技术。

那么自动驾驶汽车的经验对于更普遍的人工智能管理有什么启示?各家企业不仅要确保自己了解人工智能在系统层面的广泛影响,还需要进行监督——不应该让他们自我监管,监管机构必须主动为应用人工智能的系统定义合理的运行边界,颁发相应的许可证和法规。当人工智能应用表现出明显的安全风险时,监管机构不应该听从业界的解决方案,而应该积极主动地设置限制。

人工智能在汽车和卡车上的应用还有很长的路要走。我不是在呼吁禁止自动驾驶汽车。使用人工智能有明显的优势,有人呼吁禁止或暂停人工智能是不负责任的。但是我们需要更多的政府监管,防止发生不必要的风险。

然而,目前尚没有对汽车人工智能的监管。这部分归咎于行业的过分要求和压力,但也可归咎于监管机构缺乏能力。欧盟在监管人工智能方面比较积极主动,尤其是在自动驾驶汽车方面。在美国,联邦和州交通部门根本没有足够多的人手深入了解这项技术,或有效地倡导均衡兼顾的公共政策和法规。其他类型的人工智能也是如此。

这不是任何一届政府的问题。人工智能不仅跨越党派界限,还跨越了所有机构和各级政府。美国国防部、国土安全部和其他政府机构的工作人员都不具备有效监管先进技术所需的技术能力,特别是快速发展的人工智能。

要有效地讨论人工智能监管,参与讨论的每个人都需要具备人工智能方面的技术能力。目前,杏彩体育官网这些讨论在很大程度上受到了行业(存在明显的利益冲突)或纸上谈兵之人的影响,他们声称机器已经具有比人类更聪明的能力。除非政府机构工作人员具有了解人工智能关键优势和弱点的技能,否则关于监管的对话将不会取得丝毫有意义的进展。

要招募这样的人也很容易。比如,可以改善薪酬和奖金结构,派遣政府人员进入大学实验室,奖励为政府服务的教授,为各级政府人员提供人工智能方面的高级证书和学位课程,以及为同意毕业后在政府服务几年的本科生提供奖学金。此外,为了更好地进行公众宣教,还可以免费开放讲授人工智能的大学课程。